Das Datenvolumen in Unternehmen wächst Tag für Tag. Business-Intelligence-Lösungen helfen bei der Analyse und Aufbereitung strukturierter und unstrukturierter Daten und liefern entscheidende Erkenntnisse zur Unterneh-menssteuerung.

Meinungen auf Facebook und Twitter sind ein Datenschatz für jedes Unternehmen. Damit können sie nicht nur herausfinden, was ihre Kunden bewegt, sondern auch wie das übrige Marktpotenzial „tickt“ – leistungsfähige Analysetools vorausgesetzt. Dass dabei große Datenmengen entstehen, zeigen die Zahlen des Sportartikelherstellers Adidas: Der DAX-Konzern verzeichnet auf seinen mehr als 300 Facebook-Seiten insgesamt rund 40 Millionen Markenfans, und allein der Twitter-Account Adidas Originals (@adi_originals) hat fast 18 Millionen Follower. Adidas wertet diese „Datenberge“ aus und nutzt die Erkenntnisse für Marketing-Kampagnen oder könnte sie auch in die Produktentwicklung mit einfliessen lassen.

Auch der Handel kann von der Analyse der Social-Media-Kanäle profitieren. Der Online-Händler 7trends beispielsweise gibt Konsumenten, die im Kaufprozess ein Produkt über Facebook und Twitter an ihre Freunde oder Follower empfehlen, einen Rabatt von fünf Prozent auf den gesamten Einkauf. Unternehmen wie H&M, Vapiano oder Esprit gewähren Rabatte, wenn Konsumenten im Geschäft einchecken und ihren aktuellen Aufenthaltsort an ihre Freunde kommunizieren.

Diese Beispiele zeigen, dass schnelle Reaktionen auf Basis intelligent ausgewerteter Daten die Erfolgschancen von Unternehmen erhöhen. Um in Echtzeit handeln zu können, müssen Unternehmen mittlerweile immer größere Datenmengen immer schneller aufbereiten. Laut Analysen der Marktforscher von IDC verdoppelt sich das erzeugte Datenvolumen alle zwei Jahre, und hier kommt der Begriff Big Data ins Spiel. Er bezeichnet besonders große Datenmengen, die mit Hilfe von Standard-Datenbanken und -Daten-Management-Tools nicht oder nur unzureichend verarbeitet werden können. Problematisch sind hierbei vor allem das Erfassen, Speichern, die Suche, Verteilung, Analyse und Visualisierung großer Mengen unstrukturierter Daten. Sie liegen nicht als Tabellen oder in spezifischen Datenbank-Formaten, sondern als Text, Bilder, Video oder Audiofile vor.

Heterogene Datenquellen

Unternehmen müssen dabei immer mehr Datenquellen mit strukturierten und unstrukturierten Inhalten in ihren Analysen berücksichtigen, das heißt die Komplexität der Datenanalysen steigt. Genau diese Heterogenität der Datenquellen ist ja, neben der rasant steigenden Menge unstrukturierter Daten, eines der Merkmale von Big Data. Neben den bekannten Datenquellen, etwa den vorhandenen ERP-Systemen, kommen neue hinzu. Dazu zählen beispielsweise Daten aus M2M-Applikationen wie Sensordaten, Daten aus On-Board-Systemen oder RFID-Daten aus der Logistikkette. Weitere Beispiele für Big Data gibt es in der Finanzindustrie (Finanz-Transaktionen, Börsendaten), dem Energiesektor (Verbrauchsdaten) oder im Gesundheitswesen. In der Wissenschaft fallen ebenfalls große Datenmengen an, etwa in der Geologie (Kartierungsdaten, Erdbebenforschung), Genetik (DNA-Analysen) oder Klimaforschung (Klimamodelle).

Immer wichtiger werden mittlerweile Daten, die an den Kontaktpunkten zum Kunden entstehen und erfasst werden können: Reaktionen auf Social Media-Plattformen wie Twitter und Facebook, die Akzeptanz von Werbebotschaften aus Print- und Onlinemedien oder die Klicks auf den Webseiten eines Unternehmens. Die Herausforderung ist es, all diese – sich ständig ändernden – Daten ihrer Relevanz entsprechend zu erfassen, auszuwerten und für Business-Entscheidungen bereitzustellen.

Die Marktforscher von Gartner beschreiben die zentrale Bedeutung des Informationsmanagements mit einem eingängigen Bild: Informationen sind das Öl des 21. Jahrhunderts und die Geschäftsanalysen der Verbrennungsmotor, der damit läuft. Aus gewaltigen Datenmengen und heterogenen Datenquellen müssen Unternehmen den Rohstoff Information herausfiltern und für Business-Entscheidungen aufbereiten. Big Data liefert daher auch entscheidende Erkenntnisse für die Unternehmenssteuerung.

Unternehmen auf Kurs halten

Ohne intelligent aufbereitete Informationen wird kein Unternehmen nachhaltig erfolgreich sein, denn für die wertorientierte Unternehmenssteuerung sind Daten unentbehrlich. Beim Konzept der nachhaltigen wertorientierten Unternehmensführung (Value Based Management) geht es darum, erfolgskritische Unternehmensbereiche und

-prozesse zu bewerten. Zu entscheiden ist:

- Was sind die erfolgskritischen Bereiche je nach Geschäfts-schwerpunkt, Branche oder auch Zielstellung?

- Welche Prozesse liefern welchen Beitrag zur Wertentwicklung?

- Welche Kennzahlen (KPIs – Key Performance Indicators) und Parameter werden zur Erfolgsmessung herangezogen?

- Wie kann die Strategie in das Alltagsgeschäft umgesetzt werden?

- Wie ist sicherzustellen, dass die Bewertung nicht nur zu wenigen Zeitpunkten (etwa beim Quartalsabschluss) erfolgt, sondern mit permanenten Soll-Ist-Vergleichen und möglichen Anpassungen im operativen Geschäft verbunden ist?

In einer so genannten Balanced Scorecard werden dazu die wichtigsten Kennziffern festgelegt und deren Status („Ziel erreicht?“) mit einem kontinuierlichen Soll-Ist-Abgleich überprüft. Wichtig ist, dass Unternehmen sich auf nicht mehr als 20 KPIs konzentrieren. Das können eindeutig quantifizierbare Kennzahlen (Geld- oder Mengengrößen) sein wie Eigenkapitalquote, Stückkosten, Umsatz pro Mitarbeiter, Umsatzrentabilität, Marktanteil oder qualitative Werte wie Unternehmensimage oder Mitarbeiterzufriedenheit.

Letztlich entscheidet in jedem Unternehmen das Zusammenspiel aller relevanten quantitativen und qualitativen Faktoren über den Erfolg. Die Kennzahlen müssen zeitnah abbilden, was in der Realität geschieht, so dass die Verantwortlichen steuernd eingreifen können, um das Unternehmen auf Kurs zu halten. Dies funktioniert nur, wenn die verteilten und heterogenen Unternehmens-, Markt-, Wettbewerber- und Kundeninformationen geschickt ausgewertet werden. Das techni-sche Fundament dafür liefern Business Intelligence (BI)-Plattformen zur Unternehmenssteuerung wie WebFOCUS von Information Builders.

BI-Lösungen helfen bei der Steuerung

BI-Lösungen müssen es dem Management ermöglichen, verschiedene Methoden zu nutzen, um Geschäftsstrategien zu definieren und sie grafisch abzubilden. Auch sollten Scorecards und Strategy-Maps erstellt werden können, die darüber hinaus auch informelle Erfolgsfaktoren berücksichtigen. Eine Strategy-Map zeigt als Ursache-Wirkungs-Diagramm grafisch auf, wie immaterielle Ressourcen und die Kompetenzen der Mitarbeiter in finanzielle Ergebnisse umgewandelt werden. Sie bildet die Annahmen ab, die einer Strategie zugrunde liegen. BI-Software bietet zudem prognostische Analytik (Predictive Analytics), mit deren Hilfe sich Entscheidungen faktenbasiert vorbereiten lassen und die Zukunft aktiv gestaltet werden kann. Mit kontinuierlichen Soll-Ist-Vergleichen erhalten Unternehmen durch die prognostische Analytik ein sehr nützliches Instrument zur Unternehmenssteuerung.

Die BI-Lösung sollte zudem einfach zu bedienen und hinsichtlich der Anwender- und Lösungsanforderungen individuell anzupassen sein. Und zwar so, dass die Modifikationen auch von Fachanwendern ohne Hilfe der IT-Abteilung vorgenommen werden können. Generell wichtig ist die verständliche Datenvisualisierung, beispielsweise in Form von Dashboards. Ob für Anwender innerhalb oder außerhalb einer Organisation, die Datenvisualisierung vereinfacht das Verständnis der Geschäftsdaten auf allen Ebenen eines Unternehmens und hilft jedem, die Auswirkungen von Anwendungen besser zu verstehen.

Datenqualität verbessern

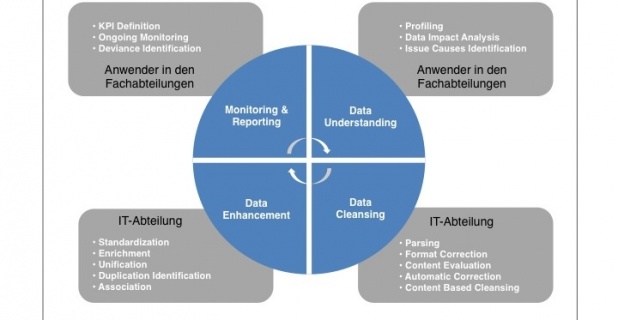

BI-Lösungen sind wie alle anderen unternehmenskritischen Applikationen auf korrekte Datenbestände angewiesen. Allerdings kommt es in den internen Datenbeständen immer wieder zu Inkonsistenzen, denn es gilt, auch neue Kanäle wie das Social Web oder die wachsende Zahl mobiler Geräte, aus denen Informationen ins Unternehmen gelangen, mit einzubeziehen. Ziel der Unternehmen muss es sein, die Daten zeitnah, genau und vollständig zu erfassen, um deren Qualität zu bewahren.

Die IT-Abteilung gewährleistet dabei die technologische Grundlage einer hohen Datenqualität für Big Data. Sie benötigt dazu die notwendigen Tools wie etwa das iWay Data Quality Center von Information Builders. Wichtig sind beispielsweise ein leistungsstarkes Datenbank-Layer und eine optimierte Matching-Engine. Funktionen für die Validierung, Standardisierung und Vereinheitlichung ermöglichen eine Datenbereinigung in Echtzeit. Sie bilden die Basis für eine verbesserte Datenqualität in den Quellsystemen.

Das Management der Datenqualität ist kein einmaliges Projekt, sondern muss kontinuierlich und nachhaltig erfolgen. Wo immer möglich, sollte eine automatische und kontinuierliche Überprüfung bereits bei der Dateneingabe (Syntax und Semantik) erfolgen. Ist kein permanenter automatischer Check möglich, muss zumindest alle zwei bis drei Monate eine manuelle Kontrolle erfolgen.

Ohne eine verlässliche und aktuelle Datenbasis kann kein Unternehmen erfolgreich sein. Die Datenströme aus den verschiedenen Quellen richtig zu steuern, ist künftig entscheidend für das geschäftliche Überleben. BI-Lösungen, die Big Data unterstützen, vereinfachen diese Aufgabe.