Die Forscher des Teams „SysPlace“ haben in den vergangenen Monaten dafür gesorgt, dass die Digitalisierung des Handels und der Industrie schneller vorankommt.

Dazu entwickelten sie unter anderem Software, die menschliche Gesten in Befehle für Maschinen umwandelt. Zudem entstanden Technologien, die verschiedene Endgeräte wie Smartphones, Tablet-PC’s und interaktive Schaufenster grenzenlos miteinander interagieren lassen. Nach 15 Monaten und zur Halbzeit des Projekts wurden nun die ersten praktischen Ergebnisse vorgestellt.

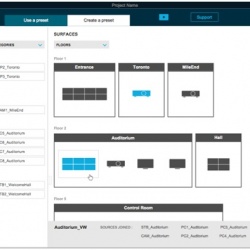

Das Bundesministerium für Forschung und Entwicklung (BMBF) unterstützt „SysPlace“ für die Laufzeit von 2,5 Jahren mit 800 000 Euro im Rahmen der Initiative „KMU-innovativ“. Projektstart war im September 2014. Ziel ist es, softwareentwickelnde KMU – wie die Projektpartner 3m5., CAS Software und ameria – und die beteiligten Hochschulen bei der Entwicklung von zukunftsfähigen Technologien zu unterstützen und diese praktisch einsetzbar zu machen. „Bei SysPlace sollen so genannte Ecosystems of Displays entstehen, die das beste Nutzererlebnis bei einer optimalen Kostenstruktur ermöglichen“, sagte Projektkoordinator Dr. Mark Hefke von CAS Software. Bisherige Ansätze waren oft daran gescheitert, dass die Kosten für einen Einsatz in der Industrie und im Handel zu hoch waren.

Auch die technischen Ziele sind groß: „Die Herausforderung offener, interaktiver Systeme liegt in der Heterogenität der Hardware- und Softwareplattformen“, sagte Christian Piechnick von der TU Dresden. „Für derartige ad-hoc System-of-Systems müssen völlig neue Entwurfs- und Programmierparadigmen entwickelt werden.“

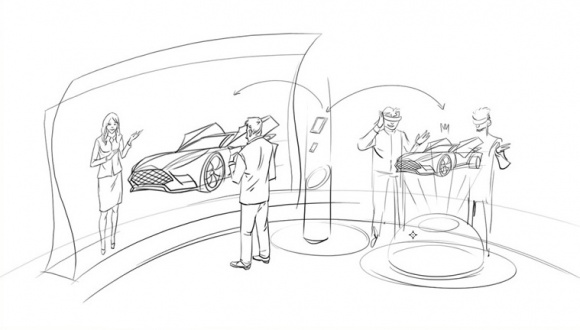

Die beiden Szenarien im Projekt „SysPlace“ orientieren sich stark an dem Bedarf, den die Projektpartner in ihrer praktischen Arbeit mit Kunden festgestellt haben. Im Szenario „Autokauf der Zukunft“ erkennen Sensoren, dass sich ein Kunde einem bestimmten Wagen oder einem virtuellen Schaufenster nähert. Eine Software verarbeitet seine Gesten, übernimmt Daten von dessen Smartphone oder speichert Konfigurationen darauf ab. Eine 3D-Animation des gewünschten Neuwagens betrachtet der Kunde schließlich durch eine Datenbrille. „Die Nachfrage nach Augmented Reality nimmt stark zu“, sagte Alexander Lehn von 3m5. „Das ist keine technische Spielerei mehr, sondern geht zunehmend in reale Projekte über.“

Dazu auch Dr. Marcus Götz von ameria: „Kunden erwarten heute vermehrt digitale Technologien in Retail Stores, wie etwa interaktive Schaufenster oder interaktive Werbetafeln mit personalisierten Angeboten. Unternehmen, die den Mehrwert einer digitalen Customer Experience über Gerätegrenzen hinweg erkannt haben, haben einen Wettbewerbsvorteil gegenüber Mitbewerbern.“

Auch Szenario 2 („Digitales Shopfloor-Management“) ist nah dran an der Praxis – hier geht es um Gestensteuerung in einer Produktionshalle (Shopfloor). Ein für die Produktionsplanung notwendiges Board erkennt, dass ein Mensch herantritt, es verarbeitet Informationen und nimmt – wie beim Autokauf – Befehle per Gestensteuerung entgegen.

Beide Szenarien verwenden handelsübliche Geräte und setzen auf preisgünstige Sensoren. Die Software-Komponenten sind so gestaltet, dass sie jederzeit auch in anderen Szenarien eingesetzt werden können. Die Interaktions-Gesten, die die Hochschule Mannheim im Rahmen ihrer wissenschaftlichen Arbeit identifiziert und beschrieben hat, werden im Laufe der verbleibenden Projektlaufzeit in Form einer Webseite aufbereitet und damit einer breiten Nutzergruppe zugänglich gemacht.

Mehr Infos unter www.sysplace.de.